Wenn Merkel plötzlich Trumps Gesicht trägt: die gefährliche Manipulation von Bildern und Videos

Es begann alles mit einem Sexfilm. Letzten Dezember stellte ein anonymer Forennutzer unter dem Pseudonym «Deepfakes» ein Video ins Netz, das die Wonder-Woman-Darstellerin Gal Gadot beim Sex mit ihrem Stiefbruder zeigt. Der Film war nicht echt: Der Programmierer hatte einen Porno genommen und auf technisch raffinierte Weise das Gesicht des israelischen Models über das Gesicht der Pornodarstellerin gelegt. Gefakte Nacktbilder sind so alt wie Bildbearbeitungsprogramme. Realistisch wirkende Fakepornos, die mit relativ wenig Aufwand erstellt wurden, erst ein paar Wochen alt. Als Grundlage diente Deepfakes eine Software von Google, die frei im Internet erhältlich ist und mit Daten gefüttert werden kann.

Der Programmierer trainierte das visuelle Gedächtnis der Künstlichen Intelligenz (KI) mittels zweier Datensätze: einer Vielzahl Sexfilme sowie Bildern und Videos der Schauspielerin, die er im Internet fand. Damit brachte er der Software bei, wie Pornos aussehen und wie Gal Gadot aussieht. Anschliessend kombinierte er diese visuellen Informationen. Das Resultat ist nicht einwandfrei: Wer genauer hinsieht, merkt, dass etwas nicht stimmt, oder erkennt Artefakte. Doch der Wonder-Woman-Porno war erst der Anfang.

Nachdem Deepfakes das Video ins Internet gestellt hatte, eröffnete er auf der Internetplattform Reddit eine Anlaufstelle für Gleichgesinnte. Im Januar wurde dort eine Anwendung veröffentlicht, welche die Herstellung von Fakevideos vereinfacht und die Technologie damit jedem zugänglich macht: Nutzer konnten jetzt ohne Programmierkenntnisse und auf Basis eigenen Bildmaterials binnen Stunden selbst solche Filme herstellen.

Eine neue Art des Fakens

Deepfakes’ Forum verzeichnet mittlerweile mehr als 50 000 Mitglieder. Die Nutzer stellen Anfragen für Videos, teilen selbst gemachte Filme und tauschen Datensätze von Promis aus, mit denen die künstliche Intelligenz trainiert wird. Die Ergebnisse werden täglich glaubhafter. Der Name «Deepfakes» ist zum Synonym für eine neue Art des Fakens geworden.

Natürlich war es nur eine Frage der Zeit, bis Nutzer der Software statt Hollywoodstars ihre Freunde, Mitschüler, Arbeitskollegen und Facebook-Bekanntschaften in Pornofilmen auftreten liessen. Erst letzte Woche stellten die Betreiber der Chatplattform Discord einen Server ab, auf dem sich Deepfaker tummelten und über die Herstellung von Fakepornos von Ex-Freundinnnen und Schulkameradinnen austauschten. «Die nichteinvernehmliche Veröffentlichung von Pornografie zieht eine sofortige Schliessung der Server sowie eine permanente Sperre der betreffenden Nutzer nach sich», sagte ein Vertreter des Unternehmens gegenüber Business Insider.

Damit spielen die Betreiber auf sogenannte «Rachepornos» an, die mit der KI-Software hergestellt werden könnten, um Personen meist weiblichen Geschlechts öffentlich blosszustellen oder zu erpressen. Für die Opfer könnten die Fakepornos gravierende gesellschaftliche Folgen haben, selbst wenn das Filmmaterial nicht echt ist. Ein gesetzliches Vorgehen gegen Einzeltäter oder Plattformen, die entsprechende Videos ohne Einwilligung der Betroffenen veröffentlichen, ist laut dem Schweizer Rechtsanwalt Martin Steiger aber möglich: «Man kann zivil- oder strafrechtlich gegen solchen Missbrauch vorgehen, auch wenn die Videos nicht echt sind.»

Problem technisch nicht lösbar

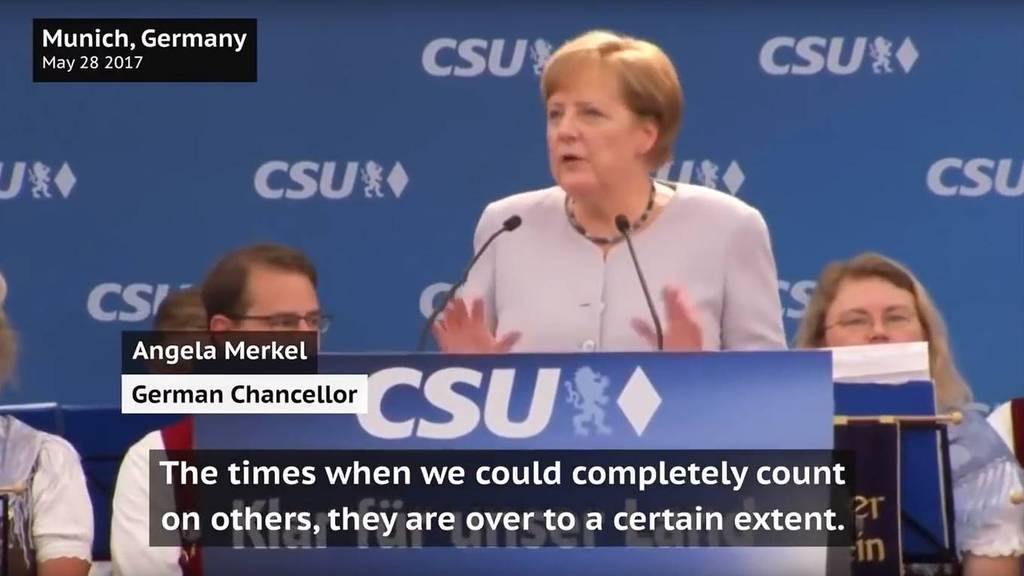

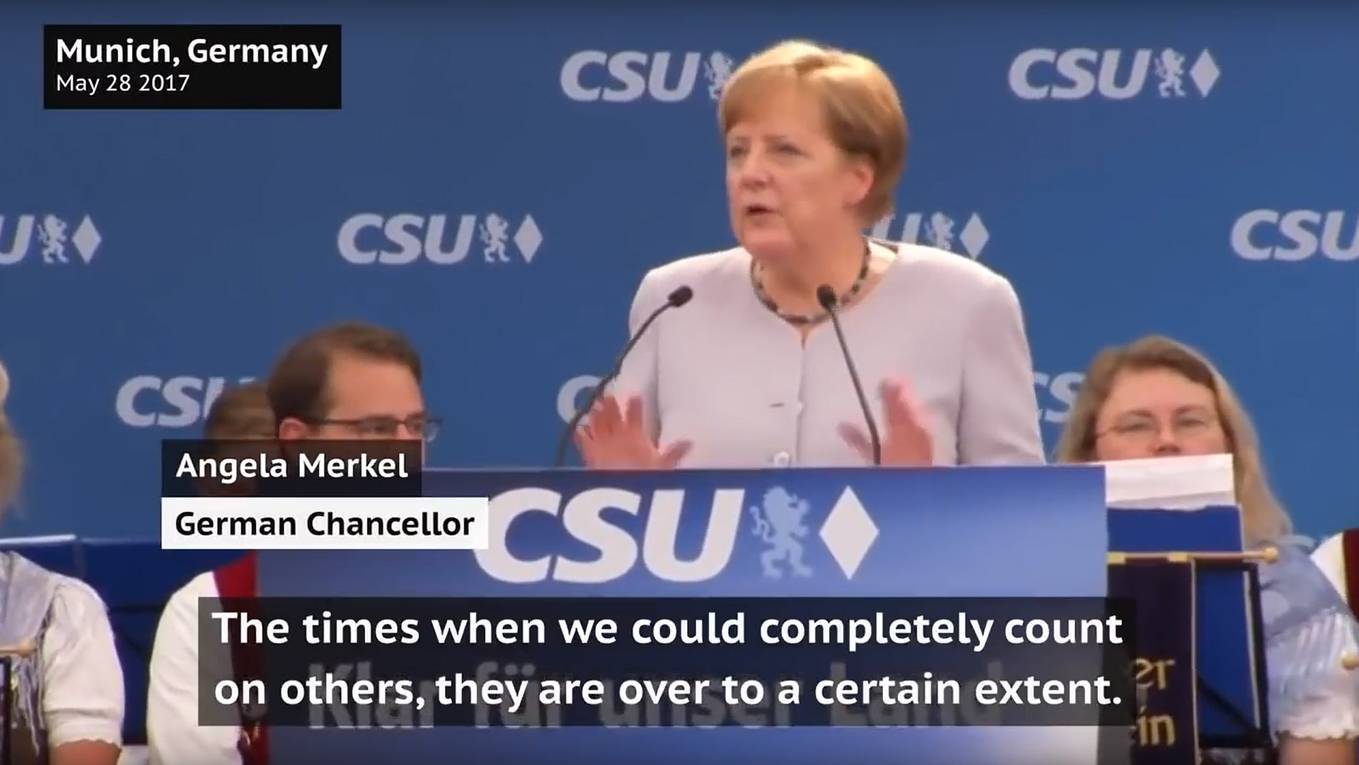

Deepfakes sind derweil nicht auf sexuelle Inhalte beschränkt und können auch für politische Zwecke missbraucht werden. Bei Youtube kursiert ein Deepfake, in dem das Gesicht des argentinischen Präsidenten Mauricio Macri durch das von Adolf Hitler ersetzt wurde, und in einem zweiten Video sieht man Angela Merkel eine Rede halten – mit dem verkniffenen Gesicht Donald Trumps. Bei diesen Beispielen ist klar, dass es sich um politische Satire handelt. Doch was ist, wenn die Manipulation nicht mehr als solche erkennbar ist?

Fakes von Bild- und Videomaterial sind so alt wie diese Medien selbst. Das Neue an den Deepfakes ist, dass die Fälschungen demnächst von jedem hergestellt werden könnten. «Wir brauchen eine laute, öffentliche Debatte», fordert deshalb der KI-Experte Alex Champandard in einem Interview mit dem Magazin «Vice». «Jeder muss wissen, wie leicht es ist, Fake-Bilder und -Videos zu erstellen, die schon in wenigen Monaten nicht mehr als Fälschungen erkennbar sein werden.»

Vor den Folgen einer Schwemme täuschend echter Fakevideos warnt auch Ian Goodfellow, ein Google-Ingenieur, der an KI-Systemen arbeitet. «Es ist ein historischer Glücksfall, dass wir uns bisher auf Videos als Beweis für Tatsachen verlassen konnten», sagte er kürzlich gegenüber dem «Technology Review» des Massachusetts Institute of Technology.

Die Technologie könne die Gesellschaft um hundert Jahre zurückwerfen, in eine Zeit, in der Bilder und Videos noch nicht für Wahrheit bürgten.

Wie ist einer solchen Gefahr zu begegnen? Durch Aufklärung und ausgeklügelte Computerprogramme, die Fakes aufdecken können, meint Champandard in einem Interview mit dem Technikportal «The Verge». Das Problem sei wahrscheinlich aber nicht technisch zu lösen. Stattdessen müssten sich Menschen in Zukunft mehr Gedanken darüber machen, welchen Medien sie vertrauen wollen. «Es wird darum gehen, ein Vertrauensverhältnis aufzubauen, zu Journalisten, Pressehäusern, Verlagen oder anderen Informationsquellen.»

von Tomislav Bezmalinovic